|

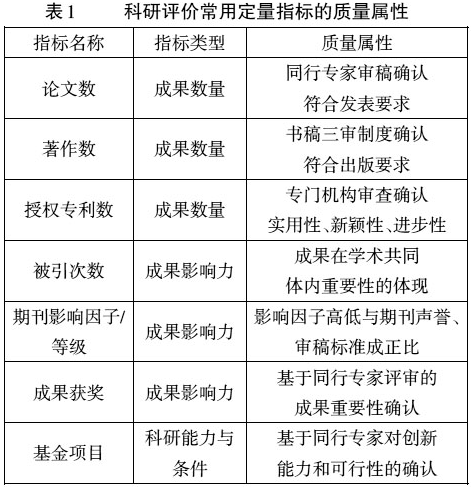

作者简介:朱军文,上海交通大学高等教育研究院副研究员,博士生导师;刘念才,上海交通大学高等教育研究院院长、教授,博士生导师,上海 200240 内容提要:质量是科学研究的内在规定性。科学研究质量既有包括问题选择、研究方法、理论运用、结论新颖性、推理过程、书写表达等内在要求,也有可以用被引次数等定量指标测量的外在表现。高校科研评价的定量指标具有质量属性。定量指标在使用中偏离质量属性的原因包括评价实践中允许用定量指标的数量标准替代质量标准的规则导向、定量指标对科学家科研行为的误导、容易定量评价的成果对不易定量评价成果的“挤出效应”和指标自身缺陷等。加强高校科研评价定量方法与质量导向的兼容性,需要实行以定量评价指标为参考的代表作同行评价制度;适当减少定量评价使用范围;实施定量指标质量标准对数量标准的单向替代;加强个性化数据平台建设,提高定量评价指标基础数据质量。 关 键 词:高校 科研评价 质量导向 定量指标 从数量扩张向质量提升转变是我国高校科技创新面临的阶段任务,也是加快内涵发展的题中之意。科研评价作为科研管理手段之一,在推动高校创新转型中具有重要导向作用。但是,我国的科研评价现状尚不令人满意。一方面,同行专家评价中的“黑幕”不时被揭开,引发对学术腐败的声讨;另一方面,定量评价方法被指责为科研泡沫的罪魁祸首。[1]以维护科学自主性和坚持科学自治理想为借口的同行评议,成为科研评价的主要方法具有天然合理性。[2]但是定量评价方法则遭遇是否还具有存在必要性的质疑。这种质疑主要基于对定量评价以数量为导向忽视质量的认识。目前高校科研评价中普遍运用的定量方法是否具有质量属性,偏离质量导向的原因在哪里,定量方法与质量导向之间如何兼容是科研评价改革无法回避的现实问题。 一、科学研究“质量”:内涵与外在表现 “质量”是各类管理活动的永恒主题。在古希腊哲学家苏格拉底、柏拉图和亚里士多德眼里,质量被理解为卓越(excellence)。18世纪中期,随着商品经济的发展,质量被界定为价值(value)。19世纪到20世纪20年代,在大规模工业生产蓬勃发展背景下,质量被定义为产品符合规格(conformance to specifications)。20世纪30年代,质量被加入统计学意义上技术标准稳定性的内涵。20世纪80年代,随着服务业在产业结构中占据主导地位,质量标准开始被理解为满足或超越客户的期望(meeting and/or exceeding customers' expectations)。[3]对于科学研究这一古老的创新活动,“质量”更是其本质规定性所在。对于科学研究质量,学术共同体和共同体外部的科学计量学专家,从截然不同的视角进行过界定。 在科学发展史上,科学家既是科研工作的主体,也始终是科研评价的主体。因此对于科研质量,科学家最有发言权。瑞典学者赫姆林(Hemlin, S. )曾就科研质量对224位不同领域科学家进行了问卷调查,结果显示科学家对此有广泛共识。科学家们认为,科研质量是对研究问题、研究方法、理论运用、结果、推理过程(逻辑)与书写表达等六个方面新颖性、严谨性、正确性、深度、广度、与学科内部和外部关联等属性的衡量。[4]当然,因学科特点与成果表达形式差异,自然科学、工程技术、医学、人文、社会等不同领域科学家对上述六个方面在本领域科研质量评价中重要性的排序略有差异。有学者认为,对质量的评价蕴含了科研工作者的个人价值判断,应将其放在特定的场域中去理解。对入职五年以内、主要是被评价对象的年轻科研人员,他们对科研质量的理解侧重研究问题的价值、对问题的揭示是否可以获得认同、论文发表期刊的影响力等,并希望这些有助于职业晋升;对于资深科学家,作为同行经常参与各类科研评价,他们对科研质量的理解根植于所在学科特点,看重研究者的能力、扎实的理论、反思的框架以及成果蕴含的思想,对科研工作的界定也更加宽泛。[5]科学家对质量概念的共识及差异,凸显了科学研究具有创新性和不确定性,应由学术共同体对重大科学发现优先权进行识别的传统,也可以看出作为学术同行在科研质量评价中不可避免的主观性以及由此衍生的一系列弊端。 科学计量学是运用数学和统计学方法对科学活动的产出(如论文数量、被引数量)和过程(如信息传播、交流网络的形成)进行定量分析,从中找出科学活动规律的一门学科。科学计量指标系统地运用于科研评价始于20世纪50年代普赖斯(Price, J. )和加菲尔德(Garfield, E. )的开创性工作。与研究领域内部的同行专家不同,科学计量学专家对科研质量的界定不是基于研究过程和研究内容,而是站在学术共同体外部对科学工作进行审视。科学引文索引(Science Citation Index, SCI)创办人加菲尔德认为,质量在性质上是难以捉摸的,人们在不同时间用不同名称来描述它,比如“重要性”(significance),“影响”(impact),“效用”(utility),“效力”(effectiveness)等。[6]莫伊(Moed, H. )认为,质量是研究工作的内在品质,是一个客观存在,但它并不是一个具有物理性质的客观实在物体。其客观存在可以从历史发展的角度来说明,即时间将证明某一研究工作的学术价值和持久性。他认为引用其他科研人员的文献是学术共同体成员之间的一种社会行为。经常被引用(高引用率)的研究成果显然会比很少被引用的研究成果更为有用。所以,一篇论文被引次数可以被认为是它的“影响”、“重要性”,或者说“质量”的精确测量。[7]从上述观点看,科学计量学的质量概念与学术共同体的同行共识是一致的。在共同体内,一篇论文被引次数被解释为影响力(influence)或者可见度(visibility)已经达成广泛共识。[8]由于被引次数需要在成果发表若干年后才能获得,因此评价实践中,论文发表期刊的影响因子往往成为代替被引次数的即时指标。在每一个专业,最好的期刊都是那些论文很难被其采用的期刊,也是高影响因子期刊,这些期刊在影响因子被发明之前已经存在。期刊影响因子运用于测量论文质量,正是因为它与观念中认同的学科最好期刊非常吻合。[9] 综上可见,学术共同体对科研质量的界定侧重从问题提出到结果呈现及应用的全过程,并以科学家个人的专业修养作为判断依据。科学计量学对科研质量的界定通过比较特定成果与其他成果获得同行引用数量差异来对质量进行间接判断。它以科学家在学术共同体内部的社会行为一致性为基础,超越了单个科学家的主观判断的局限性。二者均是以学术共同体的行为为判断基础,但一个立足学术共同体内部,一个立足学术共同体外部,一个侧重科学家个人主观的经验判断,一个侧重科学家群体行为的客观统计描述,一个是对科研质量进行直接判断,一个是对科研质量的间接判断,形成了良好的互补关系。由此可以得出,质量是学术共同体内外部专家一致公认的科学研究的内在规定性。科学研究质量既有包括问题选择、研究方法、理论运用、结论新颖性、推理过程、书写表达等内在的创新性与规范性要求,也有可以用被学术共同体内部同行引用次数多少等定量指标测量的外在影响力表现形式。内在的创新性与规范性要求与外在的影响力表现形式是两个相互补充、各有优势的衡量科学研究质量的方法体系。同行评价方法在科学研究内在质量判断上具有天然的合理性,定量评价方法通过科学研究外在影响力表现差异对其质量进行客观测量,也具有质量属性。 二、高校科研评价定量方法中的质量属性 在科学计量学出现之前,同行专家评价是判断科研质量的通用方法。但同行专家评价系统的好坏取决于被挑选出来承担评审的专家组成员,并且运转低效、代价昂贵。科学计量学基于对科研质量的独特界定,开发出了一系列简便可行的定量指标,迅速发展成为同行评价之外另一重要评价方式。 定量方法中使用最多的指标是基于一定时间窗口的出版物数量及其被引次数。在此基础上衍生出了整个定量评价指标体系,也开发出了一些新的经典指标。乌必科(Verbeek, A. )[10]、欧库布(Okuto, Y. )[11]和莫伊(Moed, H.)[12]等人分别从研究综述、经济合作与发展组织(OECD)科研评价应用和科学计量学理论探讨等角度对定量指标体系进行过系统梳理,对不同指标的性质及其缺陷进行过讨论。美国加州大学圣迭戈分校物理学教授赫希(Hirsch, J. )基于论文数量与被引次数关系提出用于评价科学家个人科研产出的h指数,[13]拓展了平衡产出数量与质量关系的新视角。 从我国高校科研评价实践看,目前广泛使用的定量指标主要有某一文献检索来源的论文数量、著作数量、授权专利数量、成果被引次数、论文发表期刊的影响因子或期刊在本学科所有期刊中的排序、科研成果获奖数、不同来源基金项目数等。它们不仅在我国广泛使用,在英国、意大利、澳大利亚等国家的科研评价实践中也被经常使用。根据指标类型,上述指标可以分为成果数量、成果影响力和科研能力与条件三类,分别具有不同程度的质量属性。(见表1)

论文数量是对评价对象科研工作原始、简化的测量,反映的是科研产量,但是它也具有质量属性。这一方面是因为学术期刊普遍实行同行专家审稿制度,在决定录用一篇论文之前,其质量已得到同行专家的基本认可;另一方面,在高校科研评价实践中普遍采用将某一检索系统收录的论文作为评价指标的做法,比如科学引文索引和中文社会科学引文索引(Chinese Social Sciences Citation Index, CSSCI)源期刊刊载的论文。相关引文索引数据库在遴选期刊时均依据其出版标准、规范性、被引用情况以及专家意见或国际多样性等指标。入选期刊总数占所在学科期刊总数比例较小,入选期刊办刊质量在各学科总体靠前。以这类引文索引收录的源期刊论文为指标,在测量产出数量的同时,显然包含了特定的质量属性。著作和授权专利等成果数量指标,也具有类似的质量属性。 被引次数、期刊影响因子及由此决定的期刊在所处领域所有期刊中的位次,是用来测量被引成果的影响或质量的主要指标,也是科学计量学界定论文质量的主要角度。但是某些领域的论文平均引用次数非常高,有些领域即使是高质量的论文,被引用的绝对次数也不高。期刊影响因子也一样,某些学科的期刊影响因子整体偏高,有些学科期刊影响因子整体都较低。因此,在不同学科领域比较论文的被引次数或刊文期刊的影响因子是不合适的。引用频次或期刊影响因子需要根据所属学科(包括属于多个学科的期刊及论文)进行正确的标准化。在被引次数指标中,总被引次数、平均被引次数、排除自引的平均被引次数等对数据的准确性要求不同,其体现的质量或影响力的准确性也不同。成果获奖是成果影响力的另一种体现,它由同行专家对其重要性或质量进行确认。基金项目是科研能力或支撑条件指标,虽在评价中被频繁使用,但其并不是成果本身,而是同行专家对申请人创新能力和可行性的确认,是对未来创新工作质量的一个预期。 从上述分析可以看出,科学计量学基于学术共同体社会行为一致性分析获得的定量评价指标本身具有质量属性,这也是其得以被广泛运用的重要原因。但在评价实践中,定量方法却往往被认为是导致我国高校科研产生重数量、轻质量现象的主要原因,是加剧学术浮躁和学术不端行为的罪魁祸首。也就是说,定量方法不仅偏离了其自身所具有的质量属性,而且催生了高校的科研泡沫。 三、高校科研评价定量方法偏离质量导向的原因 数量与质量并不是一对矛盾体。定量评价指标也具有质量属性。当前定量评价偏离质量导向的原因,可以归结为以下几个方面。 (一)以定量指标的数量标准替代质量标准的机制普遍存在 定量指标具有质量属性,但是在符合最低质量要求的基准线上方,定量指标仍然存在数量标准与质量标准使用范围差异以及数量标准与质量标准之间的替代关系矛盾。一是在满足最低质量标准前提下,定量指标的数量标准使用范围更广。在基准线上方,以数量标准作为评价对象优劣或合格与否的判断依据,简单易行,区分度显著。而定量指标的质量标准,如被引次数等质量标准对评价时间窗口设定要求严格,对基础数据的准确性要求高,采集与核对相对困难。这制约了定量指标的质量标准的应用范围和使用频率。二是在相关评价中,存在定量指标的数量标准对质量标准的替代机制,即在评价对象不符合更高质量标准的要求时,可以用数量更多的较低质量成果替代。比如,一些高校在教师职称晋升文件中依据学术声誉将期刊由高到低划分为A、B、C、D四个等级,晋升正高级职称的教师在学术论文方面需要有三篇B类以上或者九篇D类以上论文。也就是三篇D类论文可以替代一篇B类以上论文。而B类以上期刊数量少,同行评审标准严格,对论文质量要求更高。相对来说,D类期刊数量多,评审标准较低,论文发表容易。较低质量标准的成果对较高质量标准成果的替代机制,为数量扩张提供了刺激机制,为以数量取胜提供了可能,使“著作等身”的风险小于“十年一剑”,这也导致了定量指标对质量导向的偏离。 (二)定量评价对科研人员的行为产生误导 科研评价结果会直接影响到科研人员获取项目经费、职位和职称晋升机会。因此,评价方式、评价机制及其结果对科研人员的科研行为会产生不同程度的影响。广泛使用的论文发表数量、被引次数和期刊影响因子等标准不可避免地会对科学家的目标和科研行为产生潜移默化的影响。剑桥大学劳伦斯(Lawrence, P. )教授认为,过去20年,科学家已经将主要精力从科学问题和方法的探索转向了撰写论文、投稿、审议和出版的流程,满足评价标准放在了理解自然规律、揭示科学现象的前面,科学研究的本质受到影响。[14]科研人员总是设法先向高影响因子期刊投稿,然后再逐级向低影响因子期刊投稿,力争将论文发表于更高影响因子期刊。每一次投稿都要经历漫长的审稿和沟通过程,这对科研人员的时间和精力是极大的消耗,也是对科研工作的一种冲击。部分科研人员甚至改变研究策略,以跟踪热点和容易受到同行关注为重点,对于少有涉及的领域则不愿承担失败的风险。定量评价对科研人员行为产生的上述影响及其对科研质量的影响,成为定量评价被诟病的原因之一。 (三)论文等容易定量评价的成果对不可定量测量创新贡献的“挤出效应” 定量评价简便易行,使定量评价能够测量的科研产出,如论文、专著、授权专利等,在高校科研及人事管理实践中更容易得到采用和认可。管理部门对容易定量评价产出成果的认可,强化了科研人员在创新产出形式选择上的优先方向。在有限的时间里,在科学研究众多产出类型中,科研人员选择将更多的时间和精力投入到容易被认可的论文、著作、授权专利等工作上,实际上削弱了科研人员推动创新驱动经济社会发展的动力和能力。这种现象可以解释为定量评价中容易测量的产出成果对不易测量产出贡献的“挤出效应”。定量指标不易定量的创新贡献,因其难以衡量而被弱化,难以获得与容易定量评价科研成果的同等对待被削弱。在知识经济时代,科技创新推动经济社会发展的能力和水平是检验科技创新质量的终极准则。定量指标对科技创新驱动发展贡献测量的盲点及其形成的“挤出效应”,制约了高校科技创新质量与贡献的提升。 (四)定量指标自身的缺陷及基础数据问题 正如科学计量学对科研质量的界定,引文分析是对质量的一种间接测量,其侧重的是成果影响力。广泛使用的期刊影响因子也仅表明在一段时间里,该期刊上的论文平均可能被引次数,不能等同于其中某一特定论文实际获得的引用次数。另外,每一项研究产出从发表到获得认可的时间间隔差异巨大。有些成果的影响力可能是短期的,有些可能持续很长时间。真正原创性的工作通常需要两年以上才能获得学界的认可和重视,而20世纪生物学领域里最重要的一篇论文在头一个十年里罕有引用。[15]采用定量指标评价科研质量必须注意这些特点,在决定评价时点和时间窗口时应特别小心。另外,定量指标依据的基础数据也存在两个方面问题,一个与基础数据的数量有关,一个与基础数据的质量有关。[16]单一数据平台收录文献的覆盖范围与偏好、不同学科之间引用行为差异、引用动机差异、自引、多作者合作文献被引次数计算、文献的语种等都对基础数据的质量构成负面影响。定量指标及基础数据的局限,使收集研究工作完整的影响力证明材料非常困难。[17]克服定量指标及其依赖的基础数据局限也因此成为科学计量学研究的重要方向之一。 四、加强高校科研评价质量导向与定量方法兼容性的建议 2003年科技部、教育部、中国科学院、中国工程院、国家自然科学基金委员会联合印发的《关于改进科学技术评价工作的决定》,对合理使用定量评价方法已经提出明确要求。此次改革十年后,中国科学院和教育部在2012年和2013年又分别制定《关于改革科技评价,建立重大产出导向研究所评价体系的决定》和《关于深化高等学校科技评价改革的意见》,再次聚焦评价改革。改进和合理使用定量评价方法仍然是改革绕不开的重要议题。从科学计量学对科研质量的界定以及基于被引次数开展科研影响力(质量)评价等所取得的研究进展看,定量评价不是单纯的“数数”。在科研管理信息化手段不断丰富的背景下,需要改进的是强化定量指标与质量导向之间的兼容性,既充分利用定量评价客观、简便的优势,又尽可能避免其与质量导向的偏离。 (一)实行以定量评价指标为参考的代表作同行评价制度,形成专家评价与定量评价的相互验证、相互制约机制 同行评价与定量评价是从内在过程与外在表现两个方面分别对科研质量进行的评定,角度各有侧重,方法各有利弊。同行评价作为学术共同体内部的质量保障机制,有其合法性基础和与生俱来的优势。但无论在科技大国美国,还是在同行评价发源地英国,都有强烈的改革呼声。[18]我国的情况正如施一公和饶毅所言,“专家意见”不过反映了小部分官员及其赏识的科学家之间的相互理解和“默契”,并使中国学术界出现了大家心照不宣的“潜规则”。[19]这样的阐述足见同行评价之痛。近年来,科研评价中出现了将同行评价与科学计量学指标结合起来的新趋势。正如蒋国华等人所指出的,把科学计量学方法和同行评议两者有机结合起来,不仅应该,而且是可能的。[20]推广以定量指标为基础的代表作同行评价制度,既可以发挥定量评价在质量保障中的客观、简便和公正的优势,也可以借助同行专家的专业眼光弥补定量评价在研究过程和内容评价上的盲点。同时,运用科学计量学方法对科研人员提供的代表性成果质量进行定量表征,并将其作为辅助材料提交同行专家,有利于协助专家对代表性成果进行更准确判断,也可以通过将同行专家评价结果与定量评价信息之间的显著差异进行审核,制约专家做出有违“常识”的判断,形成制衡机制。 (二)适当减少定量评价使用范围,延长其评价周期,降低潜在消极影响 当前,定量评价不仅贯穿于高校科研人员职业生涯全过程,而且前置到了研究生培养环节,在评价周期上则表现为短期、频繁使用,存在明显的滥用和误用。定量评价结果对处于不同阶段的科研人员具有不同的意义,其数据采集周期也直接影响评价结果。因此,结合当前转变政府职能,推进现代大学制度建设,加快内涵发展的方向,应该适当缩减定量评价的使用范围,延长评价周期。这可以从两个方面率先突破:一是取消研究生毕业需公开发表论文的硬性要求,为培养创新人才“减负”;二是减少考核频率,延长考核周期,为科研人员潜心学术“减负”。在我国不同类型高校及其下属学院中,普遍存在要求研究生,特别是博士研究生必须公开发表学术论文才能毕业的硬性规定。反观美国、德国、英国等发达国家,以学位论文为载体,以完整的科学方法训练为基础,将探索并解决某一科学问题作为研究生教育的本质,博士研究生均没有公开发表学术论文的强制规定,更不要提硕士研究生。在按时毕业压力下,定量指标成为扭曲研究生学习动机,抑制其探索与发现好奇心与乐趣的“道具”,从人才培养源头营造了焦虑与浮躁氛围。对于教学科研人员来说,在知识经济时代,希望停留在“闲逸的好奇”驱动下从事科学研究工作显然不合时宜。但是借助定量指标,通过以年为单位“打工分”对科研工作进行考核并作为奖励或酬金发放标准,不仅有违科研规律,而且加剧了科研工作“短平快”的肤浅与浮躁。应积极推动从年度考核向聘期考核转变,辅之以代表性成果评价,为教师潜心学术“减负”。这些也是避免定量指标误用和滥用的有效举措。 (三)建立定量指标的质量标准对数量标准的单向替代机制 科研评价的首要任务是对科研活动的科学价值和社会价值进行判识,因此,不能简单地用数量代替质量,要始终将质量放在第一位。[21]正如原因分析部分所言,在目前高校科研评价或以科研成果为定量指标开展的各类评价(如职称晋升)中,涉及定量指标的合格或优劣标准的内容,有些标准侧重质量要求,有些在基本质量线上侧重数量要求。但是在评价对象达不到更高质量标准要求时,普遍存在可以用数量更多的较低质量标准成果替代难以达到的质量较高成果的机制。从治理的角度看,必须割断允许较低质量标准成果对较高质量标准成果的替代机制,建立高质量成果对低质量成果的单向替代,让低水平重复的“数量标准”失去意义。在评价实践中,一方面应牢固确定高质量成果的不可替代性,另一方面结合代表作评价制度,确定参与评价成果的最高数量限额。在成果质量高的前提下,数量可以低于限额,超过数量上限的成果则不允许纳入评价,让低水平成果失去意义。英国大学科研评价制度最新政策“卓越研究框架2014”(Research Excellence Framework, REF2014)即采用了这一办法,学校挑选出来参与评价的人员,每人最多只能提交四篇成果。在评估周期内(2008年1月1日至2013年7月31日)新入职人员根据其入职时间,工作时间越短,需提交的成果数量越少,2011年8月31日以后入职的教师只需提交一篇成果。[22]对提交成果数量上限的规定,可以引导科研人员避免将成果数量作为研究目标。 (四)加强个性化数据平台建设,提高定量评价指标的基础数据质量 有效的科学计量指标需要充分的数据支撑。因此,涵盖宽广的学科领域、足够长的时间周期和尽量多科研人员信息的数据库建设非常必要。[23]1963年科学引文索引的出现,极大促进了科学计量学的繁荣和定量指标在科研评价中的快速推广。20世纪90年代,随着互联网发展和文献数据库电子化,一些国内外知名数据平台包括知网(Web of Knowledge)、斯高帕斯(Scopus)、谷歌学术搜索(Google Scholar)、中文社会科学引文索引(CSSCI)、中国知网(CNKI)等,快速发展起来。上述数据平台将科研评价和分析功能作为重要内容,为高校科研管理提供了便利的接口。由于不同数据库收录的期刊数量、期刊学科归属划分、期刊收录时间差异等原因,基于不同数据平台检索获得的定量评价数据并不一致,单个平台的数据质量也有待进一步提高。更为重要的是上述平台在提供基础文献数据同时,对特定组织、特定科研群体及其科研人员缺乏针对性,需要做大量的数据清理工作,增加了数据使用难度。因此,针对单个组织机构建立并逐步完善适合个性化评价需要的内部共享科研产出数据平台成为提高定量指标科学性的重要基础工作。 参考文献: [1]朱军文,刘念才.科研评价:目的与方法的适切性研究[J].北京大学教育评论,2012, (3). [2]龚旭.科学政策与同行评议[M].杭州:浙江大学出版社,2009. 23—27. [3]C. Reeves, D. Bednar. Defining Quality: Alternatives and Implications[J]. Academy of Management Review, 1994, (3). [4]S. Hemlin. Scientific Quality in the Eves of the Scientist: A Questionnaire Study[J]. Scientometrics, 1993, (1). [5]J. Czellar, J. Lanarès. Quality of Research: Which Underlying Values? [J]. Scientometrics, 2013, (3). [6]E. Garfield. Citation Indexing: Its Theory and Application in Science, Technology, and Humanities [M]. Philadelphia: ISI Press, 1979. 63. [7][12]H. Moed. Citation Analysis in Research Evaluation [M]. New York: Springer, 2005. 25—34. [8][11]Y. Okubo. Bibliometric Indicators and Analysis of Research Systems: Methods and Examples [R]. OECD Science, Technology and Industry. Working Papers. OECD Publishing, 1997. 8—9, 24—31. [9]E. Garfield. Journal Impact Factor: A Brief Review [J]. Canadian Medical Association or Its Licensors, 1999, (8). [10]A. Verbeek, et al. Measuring Progress and Evolution in Science and Technology-I: The Multiple Uses of Bibliometric Indicators [J]. International Journal of Management Reviews, 2002, (2). [13]J. Hirsch. An Index to Quantify an individual Scientific Research Output [J]. Proceedings of the National Academy of Sciences of the United States of America, 2005, (46). [14]P. Lawrence. 科学的不当评价[J]. 科学观察,2008, (2). [15]R. Olby. Quiet Debut for the Double Helix [J]. Nature, 2003, (421). [16]R. Kostoff. The Use and Misuse of Citation Analysis in Research Evaluation[J]. Scientometrics, 1998, (1). [17]T. Penfield, et al. Assessment, Evaluations, and Definitions of Research Impact: A Review[J]. Research Evaluation, 2014, (23). [18]达里尔.E·楚宾,爱德华.J·哈克特.难有同行的科学[M].北京:北京大学出版社,2011. 191—208. [19]Y. G. Shi, Y. Rao. China's Research Culture [J]. Science, 2010, (5996). [20]蒋国华,等.科学计量学与同行评议[J].中国科技论坛,1998, (6). [21]金碧辉.高论文量与低引文量带给我们的思考——关于科技评价的价值导向与定量指标[J].科学学与科学技术管理,2004, (3). [22]REF2014. Panel Criteria and Working Methods [EB/OL]. http://www. ref. ac. uk/pubs/2012-01/#d. en. 69569. 2014-04-06. [23]P. Andras. Research: Metrics, Quality, and Management Implications [J]. Research Evaluation, 2011, (2). (责任编辑:admin) |